Grundlagen KI Teil 2: Einführung Intelligenz

Artikelübersicht

Im letzten Artikel zu diesem Thema haben wir neun Tests für künstliche Intelligenz betrachtet, ohne eine Definition für KI zu finden.

Der Plan für heute ist, die Definition für Intelligenz herauszusuchen, um dann die Definition für künstliche Intelligenz abzuleiten.

Die Frage ist: Was ist Intelligenz und wie kann man sie messen?

Ich begann also nach der Definition von Intelligenz zu suchen und mir Notizen zu machen. Dann stieß ich auf ein Bild.

Dieses Bild zeigt verschiedene Ansätze um festzustellen, ob eine Entität intelligent ist.

Diese sind:

- systematisches Testen (Psychometrie)

- algorithmische Informations Theorie (Problemkomplexität)

- kognitive Modelle (Simulation)

- Leistung bei bestimmten Aufgaben (klassische KI)

- Observation Interview (Turing-Test)

Ich wusste durch meine Recherchen, dass die Psychometrie Intelligenz definiert und testet und ich wusste, dass der Turing-Test eine andere Definition von Intelligenz hat, also vermutete ich, dass die Ansätze verschiedene Definitionen von Intelligenz darstellen.

Also werden wir nachfolgend die einzelnen Ansätze beschreiben, um die Unterschiede und Gemeinsamkeiten aufzuzeigen, sowie zu klären, wofür man die jeweiligen Ansätze nutzen kann.

Observation

Bis ins späte 19. Jahrhundert gab es keine Messmethoden für Intelligenz. Man beobachtete Lebewesen und definierte somit ihre Intelligenz. Auch Unterschiede zwischen Menschen wurden so festgelegt. Menschen sind intelligenter als Tiere, die oberen Stände oder Schichten intelligenter als die Unteren. Jemand, der Schach spielen oder mehrere Sprachen sprechen kann, einer der viel weiß, ist intelligent.

Die Menschen damals glaubten allerdings auch, dass es Savanten gibt. Also Menschen mit Inselbegabung. Die können zwar zum Beispiel sehr gut Schach spielen, aber sonst können sie nicht viel. Und das ist nicht das Gleiche wie Intelligenz.

E. coli Bakterien sind intelligenter als ein Stein, Hunde intelligenter als Bakterien und Menschen intelligenter als Hunde. Die meisten Menschen brauchen kein genaueres Verständnis von Intelligenz.

Aber Tester, Psychologen oder Wissenschaftler, die sich mit Intelligenz befassen, sollten präzise definieren können was Intelligenz ist und sie sollten einen zuverlässigen Test dafür haben.

Die ersten Messungen

Die ersten Versuche Intelligenz zu messen entstanden im späten 19. Jahrhundert. Intelligenz wurde damals verstanden als

… die Fähigkeit von Menschen Anerkennung und Erfolg in ihren beruflichen Bestrebungen zu erlangen, insbesondere akademischen Erfolg.

-Übersetzung des Autors

(people’s ability to gain reputation and success in a professional endeavor, particularly, scholarly ones.) –Francis Galton

Paul Broca, Francis Galton und Willhelm Wundt versuchten diese Leistungsfähigkeit durch Schädelmaße, Armlänge, Beinlänge, die Reaktionsgeschwindigkeit oder durch die Fähigkeit, über die eigenen Gedanken zu reflektieren, zu messen. Diese Messungen korrelierten nur insignifikant mit der akademischen Leistungsfähigkeit. Einfach gesagt diese "Tests" messen nicht, was sie messen sollen.

Tests die nicht messen, was sie sollen, helfen uns nicht. Allerdings werden wir uns die Definition im Hinterkopf halten. Intelligenz als "die Fähigkeit Anerkennung und Erfolg zu erlangen, insbesondere akademischen Erfolg"

Systematisches Testen und Psychometrie

Alfred Binet war beeindruckt von Galtons Versuch individuelle Unterschiede durch standardisierte Tests zu untersuchen.

Er begann ebenfalls Tests an Schriftstellern, Mathematikern, Schachspielern und Künstlerns durchzuführen und er untersuchte die mentalen Fähigkeiten seiner Töchter. Im Auftrag der französischen Regierung entwickelte er mit Théodore Simon einen Test der geistigen Fähigkeiten für Kinder. Dieser testete Aufmerksamkeit, Gedächtnis und Problemlösungsfähigkeiten. Diese Aufgaben sollten möglichst trennscharf ab einem bestimmten Alter erfüllt werden können.

Aufgabenbeschreibung:

Die Skala umfasst 20 Aufgaben mit steigender Komplexität, wobei die einfacheren Aufgaben jeder lösen kann. Die ersten Testfragen bewerteten beispielsweise die Fähigkeit des Kindes, dem Prüfer mündlich zu antworten oder einem Lichtstrahl zu folgen. Zu den etwas schwierigeren Aufgaben gehörte das Wiederholen einer Reihe von zwei Zahlen und einfachen Sätzen sowie das Erklären von einfachen Vokabeln wie Löffel, Mutter oder Haus. Zu den schwierigeren Testaufgaben gehörten das Wiederholen von sieben zufälligen Zahlen, das Finden von drei Reimen für bestimmte Wörter und das Bilden von Sätzen aus drei vorgegebenen Wörtern. Anspruchsvollere Testaufgaben verlangten von den Kindern, den Unterschied zwischen Paaren von Dingen anzugeben, Zeichnungen aus dem Gedächtnis zu reproduzieren oder Sätze aus drei vorgegebenen Wörtern zu bilden. Mit ausführlichen Anweisungen für die Durchführung der Tests und die Bewertung der Antworten bemühte sich Binet um Stringenz und gestaltete seine Verfahren und Tests so fair wie möglich.

Binet selbst glaubte, dass man mit diesem Test lediglich feststellen konnte, ob ein Kind zusätzliche schulische Hilfe brauchte. Er hielt Intelligenz für zu komplex um sie messen zu können, dennoch gilt dieser Test heute als erster Intelligenztest.

Und das scheint mir logisch zu sein, denn ein Kind, das zusätzliche schulische Hilfe braucht, erlangt keinen (akademischen) Erfolg. Hier wird also die Abwesenheit von Intelligenz getestet sowie Galton sie definiert.

Andere Forscher hielten Intelligenz für messbar. Charles E. Spearman, ein Schüler von Wundt, war der Überzeugung Intelligenz ist als ein Faktor messbar, der mentale Unterschiede zwischen Menschen erklären kann, den er Generalfaktor, oder auch G-Faktor nannte.

Louis L. Thurstone hingegen war der Überzeugung mentale Fähigkeiten ließen sich messen als sieben verschiedene Primärfaktoren.

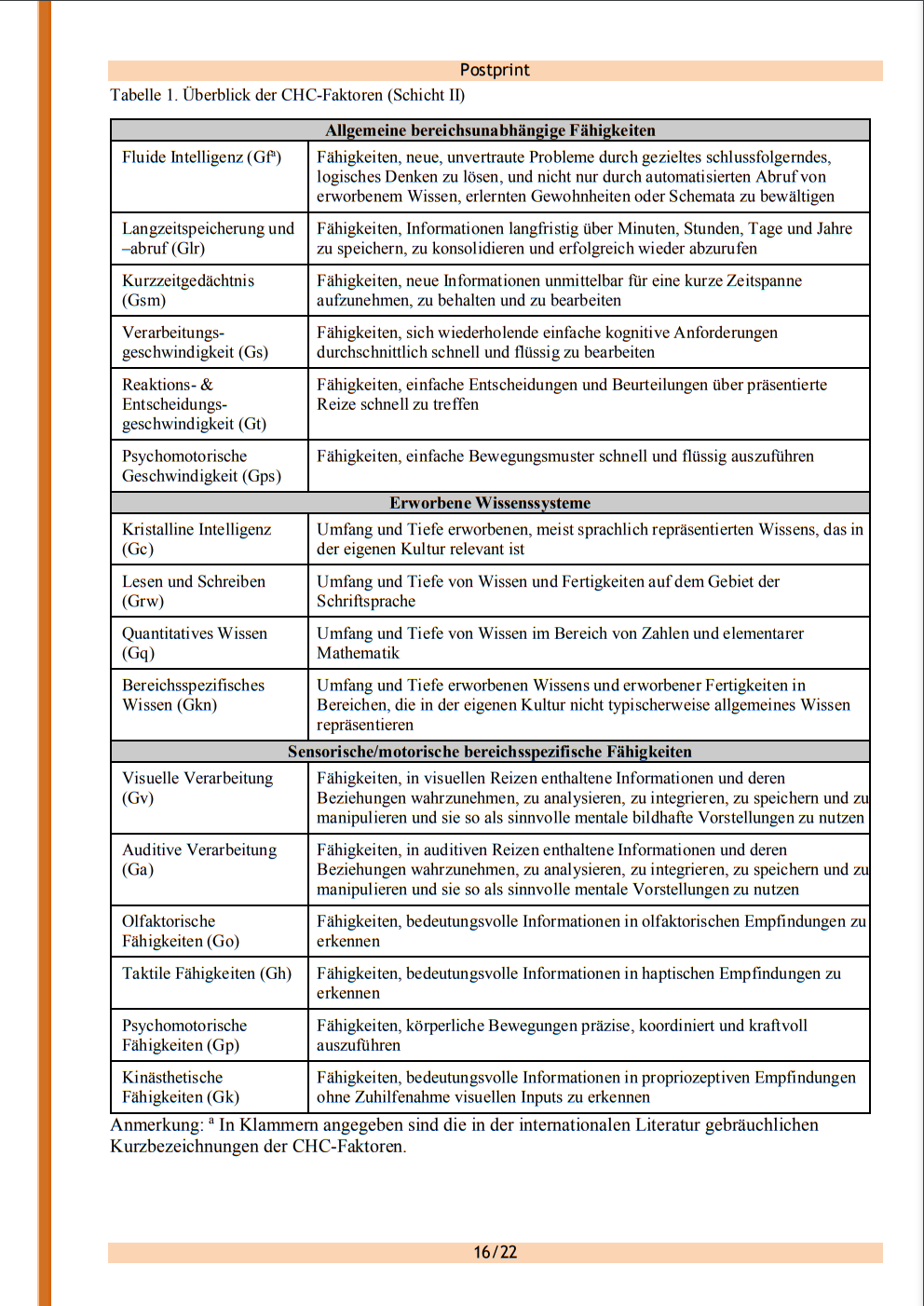

Hier verweise ich der Vollständigkeit halber auf Thurstones spätere Anerkennung des G-Faktors, das neue Modell von Raymond B. Cattell und John Leonard Horn, das weitere Modell von John B. Caroll, die Integration dieser beiden Arbeiten zum Cattel-Horn-Carroll-Modell (CHC-Modell), Horns konsequente Argumentation gegen die Existenz eines G-Faktors, die Zweifel an der Nützlichkeit und Belegbarkeit des CHC-Modells von Carroll selbst und ich verweise darauf, dass es weitere Forscher gibt die ich nichtmal nenne.

Bei ihren Arbeiten haben verschiedene Forscher allerdings festgestellt, dass die Primärfaktoren nicht wie ursprünglich angenommen unabhängig sind, sondern signifikant korrelierten.

Außerdem gab es Unterschiede zwischen den mentalen Fähigkeiten von Menschen, welche nicht auf den Generalfaktor zurückzuführen sind.

Dabei ist ein neues Intelligenzmodell entstanden. Das Cattell-Horn-Carroll-Intelligenzmodell.

Die Cattell-Horn-Carroll Theorie für kognitive Fähigkeiten ist die umfassenste, empirisch belegte psychometrische Theorie der Struktur der kognitiven Fähigkeiten. Sie stellt die integrierten Arbeiten von Raymond Cattell, John Horn und John Carroll dar.

-Übersetzung des Autors. (The Cattell-Horn-Carroll (CHC) theory of cognitive abilities is the most comprehensive and empirically supported psychometric theory of the structure of cognitive abilities to date. It represents the integrated works of Raymond Cattell, John Horn, and John Carroll)

–The Cattell-Horn-Carroll Theory of Cognitive Abilities

Dieses Intelligenzmodell besteht aus dem G-Faktor auf der oberen Ebene (Stratum III), aus weiten Fähigkeitsbereichen auf der mittleren Ebene (Stratum II) und aus engen Fähigkeitsbereichen auf der unteren Ebene (Stratum I). Die Fähigkeitsbereiche in diesem Modell sind nicht fest. Wenn es Belege für einen neuen unabhängigen Bereich gibt, kann dieser ergänzt werden.

Es gibt also eine Intelligenz mit verschiedenen (Sub-)Intelligenzbereichen.

Von diesen Stratum-II-Fähigkeitsbereichen werden fluide Intelligenz, kristalline Intelligenz und sensorische Fähigkeiten noch wichtig. Für unsere Zwecke definiere ich diese Begriffe wie folgt:

- Die fluide Intelligenz ist die Fähigkeit neue, unvertraute Probleme durch logisches Denken zu lösen.

- Die kristalline Intelligenz ist das erlernte Wissen.

- Sensorische Fähigkeiten sind die Fähigkeiten bedeutungsvolle Informationen aus Sinneseindrücken wahrzunehmen.

Wenn man also behauptet, dass Menschen nicht intelligent sind, sondern nur viel wissen, dann besagt man eigentlich ihre kristalline Intelligenz ist hoch, allerdings mangelt es ihnen an fluider Intelligenz.

Die anderen breiten Fähigkeitsbereiche werden für diesen Artikel nicht wichtig. Aber für den neugierigen Leser hier ein Überblick.

Intelligenz ist die Fähigkeit unter Verwendung des Gedächtnisses und logischen Denkens Probleme zu lösen.

-Übersetzung des Autors (The construct of intelligence is defined as the capability to solve problems using memory and reasoning(…))

-Issues in the Intellectual Assessment of Hearing Impaired Children S.7

Kognitive Psychologie

Die Psychometriker haben Intelligenz gemessen und kategorisiert, allerdings sagen sie nicht, wie Menschen denken.

Man stelle sich zum Beispiel einen Probanden vor, der bei folgender Analogie-Aufgabe scheitert: "Europa ist zu Spanien wie Nordamerika zu … 1. Alaska 2. Kanada 3.Venezuela 4.New York". Dieser Proband könnte einen Mangel an fluider Intelligenz ("logisches Denken) besitzen. Also das genannte Problem ist ihm zu kompliziert. Oder einen Mangel kristalliner Intelligenz ("Gedächtnis") besitzen, wenn er zum Beispiel nicht weiß, was Spanien ist.

Außerdem könnte er einen Mangel an sensorischen Fähigkeiten haben. Ein Blinder kann diese Aufgabe nicht lösen, wenn er das Problem nicht lesen kann. Man benötigt zum Lösen dieser Aufgabe, sowie der meisten Aufgaben, sensorische Fähigkeiten, fluide Intelligenz und auch kristalline Intelligenz. Eine kognitive Analyse lässt Forscher herausfinden, warum eine Aufgabe nicht gelöst werden konnte.

Die Kognitive Psychologie bietet also keine neue Definition, keine neue Testmethode für Intelligenz, sondern ergänzt das vorhandene Modell mit einer Erklärung dafür, welche Schritte verwendet werden um Intelligenztestaufgaben zu lösen.

Teilweise werden Computermodelle geschrieben, die das Denken von Menschen simulieren sollen. Zwei Beispiele dafür sind das ACT-R Modell (ein Modell, der grundlegenden Kognitionsprozesse im menschlichen Gehirn mit welchem eine Vielzahl von Prozessen simuliert werden können.) und das Atkinson-Shiffrin-Modell (ein Modell des menschlichen Gedächtnisses). Diese Computermodelle können dann Vorhersagen über menschliche Denkprozesse errechnen. Diese Vorhersagen betreffen die gegebene Antwort und die Reaktionszeit. Die Antworten sollen dabei möglichst genau die menschliche Antwort widerspiegeln, also sollen sie auch menschliche Fehler wiederholen.

Diskussion

Anschließend zur Beschreibung von Intelligenzforschung, wollen wir nun noch auf häufige Kritikpunkte eingehen.

Es gibt Kritik an der Definition von Intelligenz, an der Verwendung von Intelligenztest-Ergebnissen und an der Messung von Intelligenz.

Die Definition von Intelligenz beinhaltet, so die Kritiker, lediglich die rationale Intelligenz. Andere Typen der Intelligenz werden nicht betrachtet.

Hier werden emotionale Intelligenz, soziale Fähigkeiten, moralische Entwicklung und Motivation aufgelistet.

Dort verweist man darüber hinaus auf Emotion und Einstellungen.

Die Definition von Intelligenz ist rationales Denken, Problemlösungsfähigkeiten, die Fähigkeit Komplexität zu "entschlüsseln".

Wenn wir das Konstrukt der Intelligenz ergänzen mit Motivation, emotionaler Intelligenz sozialen Fähigkeiten, Moral oder Emotion, dann müssten wir die Definition verändern. Logisch betrachtet macht das also keinen Sinn.

Wie sieht es in der Praxis aus. Wir verwenden Intelligenz um Erfolg vorherzusagen, fehlt da was?

Nun welche Prädiktoren haben wir für und Erfolg:

Hier wird untersucht, mit welchen Variablen man akademischen Erfolg vorhersagen kann. Dies kann man mit fluider Intelligenz (0,76) "Need for Cognition" (0,43), Offenheit (0,38), "school Value" (0,35) und "Intellectuel self concept" (0,32).

"Need for Cognition" ist das Interesse an kognitiv anstrengenden Aufgaben.

Offenheit ist ein Persönlichkeitsmerkmal aus dem Fünf-Faktoren-Modell(Big Five) und beschreibt das Interesse an neuen Erfahrungen, Erlebnissen und Eindrücken.

School Value ist der Wert den ein Individuum der Schulbildung einräumt

Intellectuel Self Concept beschreibt wie sehr sich ein Individuum im Bezug auf den akademischen Betrieb als kompetent und fähig betrachten

Hier wird die Vorhersagekraft verschiedener Messwerte für berufliche Leistung zusammengetragen. Die beste Vorhersagekraft hat Intelligenz (0,51), gefolgt von einzelnen Persönlichkeitsmerkmalen "selten größer als 0,3 für einzenlne Merkmale" (rarely above r = 0.30 for individual traits)

Intelligenz ist ein Prädiktor für Erfolg in den meisten Berufen (Ausnahmen sind kognitiv einfache Aufgaben. Erfolg bei diesen ist unabhängig von Intelligenz)

Die Facetten des Fünf-Faktoren-Modell erklären hingegen den Erfolg in spezifischen Berufen. Offenheit erklärt Erfolg in kreativen Berufen, Extraversion im Verkauf und Gewissenhaftigkeit in "methodischen" Aufgaben.

Intelligenz ist also ein Prädiktor für Erfolg und Anerkennung, insbesondere für akademischen Erfolg. Nicht nur der Wichtigste sondern auch der Zuverlässigste

Kritik ist berechtigt, wenn behauptet wird Intelligenz ist der einzige relevante Faktor. Die Kritik sollte dann allerdings weit verbreitete, einheitlich definierte und zuverlässig messbare Konstrukte als Alternative nennen. Das Fünf-Faktoren-Modell scheint mir am besten geeignet, insbesondere mit den 25 Subfaktoren, da es weit verbreitet ist und viele andere Konzepte erklärt.

Da sind wir schon im zweiten Kritikpunkt: Die Verwendung von Intelligenztests.

Intelligenz korreliert mit akademischen und beruflichen Erfolg, mit Gesundheit, (geringerer) Wahrscheinlichkeit einer Scheidung, (geringere) Anzahl der Monate die ein Individuum in Haft verbringt.

Trotzdessen sollten Staatsanwälte, Eheberater oder Ärzte keinen Intelligenztest machen, sondern vernünftige Tests für Schuld, Eheerfolg oder Gesundheit durchführen.

In Einstellungsverfahren bei einfachen Berufen haben Intelligenztest ebensowenig Aussagekraft. Die Berufe sind einfach, man benötigt keine Intelligenz, sondern Gewissenhaftigkeit (Fünf-Faktoren-Modell). Und auch bei akademischen Auswahlverfahren sollte man mit Intelligenztests vorsichtig sein. Denn Menschen mit Hochschulreife sind schon nach Intelligenz vorsortiert.

Nun wollen wir uns den Kritiken an der Intelligenzmessung widmen:

- Wenn ein Intelligenztest abgeschlossen wurde, dann besagt das Ergebnis nur, wie man im Vergleich zu anderen Probanden abgeschlossen hat, denn Intelligenztests erstellen eine Ordinalskala. Entweder wird diese in Perzentil zum Beispiel 50. Perzentil oder in IQ-Werten zum Beispiel 100 angegeben. Man könnte auch sagen: "Du erreichst den 500. von 1000 Plätzen" Das bedeutet, dass 50 Prozent der Probanden ein geringeres oder gleich hohes Ergebnis erreicht haben. Ein Problem dabei ist, dass IQ-Tests nicht ohne weiteres vergleichbar sind, da die Vergleichsgruppe unterschiedlich sein könnten. Außerdem erzeugt dies Messungenauigkeiten bei stark von der Norm abweichenden Intelligenzwerten. Denn die Wahrscheinlichkeit für ein Testergebnis von unter 70 oder über 130 liegt bei jeweils 2,5%. Mit so wenigen Vergleichswerten wird das Ergebnis sehr ungeanau. Deswegen würden die meisten IQ-Test unter 70 oder über 130 angeben. Genauere Werte müssen mit speziellen IQ-Tests für hochbegabte oder beeinträchtigte Menschen getestet werden. Die aufgrund der anderen Vergleichsgruppe nicht mit den anderen Tests vergleichbar sind.

- IQ-Tests testen Intelligenz, indem verschiedene Aufgaben für deren Lösung man Intelligenz benötigt zusammengefügt und anschließend an vielen Menschen kalibriert werden, um den genannten Vergleichswert zu erhalten. In diesen Aufgaben gut oder schlecht abzuschneiden, ist meistens auf eine höhere oder niedrigere Intelligenz zurückzuführen, allerdings nicht immer. Einerseits treten Lerneffekte ein (siehe Test-Retest-Reliabilität), das bedeutet, die IQ-Werte steigen, wenn man denselben oder ähnliche Tests wiederholt durchführt. Andererseits kann ein schlechtes Ergebnis daher rühren, dass ein Proband nicht so gut lesen kann oder die Testsprache ist nicht die Muttersprache des Probanden (Mangel an kristalliner Intelligenz), von blinden, schwerhörigen und tauben Menschen ganz abgesehen (Mangel an sensorischen Fähigkeiten). In diesen Fällen sind die erlaubten Schlussfolgerungen lediglich, der Proband kann die Sprache nicht sprechen, kann nicht sehen oder hat ein geringes Sprachverständnis. Und Intelligenztests für diese Probanden sind, wenn vorhanden, weniger aussagekräftig, da die Vergleichsgruppe geringer ist. Außerdem sind sie nicht mit den anderen Tests vergleichbar.

- Umweltfaktoren spielen eine Rolle wie gut ein Intelligenztest Intelligenz misst. Die Ergebnisse fallen schlechter aus, wenn der Proband müde, gestresst oder erkrankt ist. Außerdem stellt sich die Frage: Will der Proband ein gutes Ergebnis erzielen? Er kann zum Beispiel mit Absicht die falsche Antwort auswählen, wenn er nicht als Streber gelten möchte. Oder er lässt sich Zeit mit den Aufgaben, weil seine Kultur Schnelligkeit keinen hohen Stellenwert einräumt.

Die Probleme 1 und 2 können mit der Shannon-Entropie gelöst werden:

Ratio scales are rare in the cognitive sphere, mostly because norm-referenced tests constitute the vast majority of measurement methods currently in use. In a normreferenced instrument, the performance of each examinee is interpreted with reference to a relevant standardization sample (Petersen, Kolen, & Hoover, 1989). Barrett (2000) (…)concludes that there are no units of “g,” no units of “IQ,” and no units of “intelligence.” The scores on psychometric tests represent an ordinal scale, merely ranking individuals according to their overall performance on a variety of complex mental tasks;

–Phillipe E. Ruiz, Measuring fluid intelligence on a ratio scale,2009,Seite 440.Verhältnisskalen sind in den kognitiven Wissenschaften selten, hauptsächlich, weil normbezogene Tests den Großteil der momentan verwendeten Messmethoden darstellen. In Normbezogenen Tests wird die Leistung eines Probanden mit der Leistung einer Normgruppe verglichen. Barret kommt zu dem Entschluss, dass es keine Einheit "g" gibt, keine Einheit "IQ" und keine Einheit von "Intelligenz". Die Ergebnisse auf psychometrischen Tests sind Ordinalskalen, die Individuen lediglich nach Leistung in verschiedenen, komplexen, mentalen Aufgaben einordnen. -Übersetzung des Autors

(…) survival in a variable environment requires an internal model whose complexity matches the complexity of the environment to be controlled; also, the reduction of the sensed environment to an adequate map requires a strong mechanism of categorization. He further defines a measure of cognitive complexity as the statistical entropy of the system under consideration. (…) To summarize as a hypothesis: Information entropy is a measure of complexity that can measure fluid intelligence on a ratio scale. –Phillipe E. Ruiz, Measuring fluid intelligence on a ratio scale,2009,Seite 440.

…für das Überleben in einer wechselhaften Umgebung [ist] ein internes Modell nötig, dessen Komplexität genau so groß ist, wie die Komplexität der Umgebung, die kontrolliert werden soll; Außerdem muss, um die wahrgenommene Umgebung auf eine adequate Karte zu reduzieren, ein starker Kategorisierungsmechanismus vohanden sein. Er definiert weiterhin die statistische Entropie des betrachteten Systems als Maß für die kognitive Komplexität (…)

Um die Hypothese zusammenzufassen: Informations Entropie ist ein Maß der Komplexität, dass fluide Intelligenz auf einer Verhältnisskala messen kann. -Übersetzung des Autors

Phillipe E. Ruiz, der Autor, stellt weiterhin einen Intelligenztest vor, der wie andere psychometrische Tests genormt wurde und der hohe Korrelationen mit G aufweist.

Also es ist ein funktionierender Intelligenztest. Dieser Test besteht auf den ersten Blick aus typischen Intelligenztest-Aufgaben wie man sie auch aus den "Ravens Progressive Matrices" kennt. Allerdings sind diese Aufgaben so konstruiert, dass ihre Komplexität mit der Shannon-Entropie berechnet werden kann.

Die Shannon-Entropie ist ein Maß für den Informationsgehalt in einer Zeichenmenge – also deren Komplexität.

Bei diesen Aufgaben muss das Bildchen ausgewählt werden, welches nicht in die Reihe passt.

Bei normalen Intelligenztests, misst man wie viele Probanden diese Aufgabe lösen können, dies ist hier auch passiert, weshalb dieser Test die klassische Ordinalskala besitzt, die alle IQ-Tests besitzen. Allerdings kann mit der Shannon-Entropie die Komplexität der Aufgaben berechnet werden. Und da nach Heylighen die Komplexität des internen Modells genau so groß sein muss, wie die Komplexität der Umgebung, kann mit der Shannon Entropie auch die maximale Komplexität des internen Modells berechnet werden. Somit kann die Intelligenz der Testperson als Entropie angegeben werden und somit als Verhältnisskala.

Wenn die Schwierigkeit einer Testaufgabe definiert werden kann, ohne den Anteil der Probanden auswerten zu müssen, der sie lösen kann, dann sind die Testergebnisse über das gesamte Intelligenzspektrum konstant aussagekräftig. Es bedarf also keiner speziellen Tests für über- oder unterdurchschnittliche Ergebnisse. Außerdem sind verschiedene Intelligenztests mit dieser Schwierigkeitseinordnung miteinander vergleichbar. Auch Tests für Blinde, Taube und Schwerhörige sind, wenn ihre Schwierigkeit mit der Shannon-Entropie berechnet werden kann, mit anderen Tests vergleichbar und genau so aussagekräftig.

Shannon-Entropie kann Intelligenztests und deren Ergebnisse aussagekräftiger und objektiver machen. Anders ausgedrückt Shannon-Entropie kann die Probleme 1 und 2 lösen. Ruiz bietet keine neue Testmethode oder Definition für Intelligenz.

Es gibt nun einige weitere Forscher, welche Entropie nutzen um Intelligenz zu erklären und zu berechnen.

Robert L. Fry versucht intelligente Prozesse mit Thermodynamik zu erklären.

Dabei verwendet er die Boltzmann-Entropie, also die Gleichverteilung von Energie. Diese nimmt global immer zu. Und lokal nimmt sie auch meistens zu. Wenn die lokale Entropie abnimmt, so Frys Implikation, dann ist der Grund dafür, ein Intelligentes System. Dieses minimiert die lokale Entropie mit der Absicht, mehr Energie verwenden zu können.

Wei Su versucht des Weiteren mit der Boltzmann Entropie der lokalen Umgebung und der Shannon Entropie des internen Modells die Intelligenz eines Systems zu berechnen.

Mit Sus Ansatz könnte man theoretisch die Intelligenz von jeder Handlung und von jedem System berechnen. Und somit beweisen, dass E.coli intelligenter ist als ein Stein. (streng genommen nicht die Intelligenz eines Systems, da ein System eventuell nur einen "Teil seiner Intelligenz" verwendet – weil es müde, gestresst, hungrig oder demotiviert ist. anders ausgedrückt, Problem 3 kann auch mit diesem Ansatz nicht gelöst werden… man berechnet oder misst lediglich die Intelligenz einer Handlung)

Ich glaube, dass diese Definition insofern mit den anderen Definitionen vereinbar ist, dass das Lösen von Problemen meistens (oder immer) einhergeht, mit der Verringerung von Komplexität. Und diese Komplexität wird in Entropie gemessen. Entweder die Komplexität einer Information (Hier reden wir von Shannon-Entropie) oder die Verrringerung von Komplexität in der lokalen Umgebung. (Hier reden wir von Boltzmann-Entropie). Wenn man aufräumt, etwas repariert oder renoviert verringert man die Entropie der lokalen Umgebung.

Ein Unterschied besteht allerdings darin, dass die Psychologie besagt Intelligenz ist die Fähigkeit des Menschen komplexe Probleme zu lösen. Das heißt unabhängig davon, ob sie genutzt wird oder nicht, während hier nur gemessen würde, was das System tatsächlich macht. Außerdem sind Frys und Sus Ansätze nach meinen Informationen lediglich theoretischer Natur.

Leistung bei bestimmten Aufgaben

Da wir ausreichend besprochen haben, wie Intelligenz üblicherweise definiert wird, kommen wir nun zur Definition von künstlicher Intelligenz.

Ein KI System kann evaluiert werden, durch die Leistung bei bestimmten Aufgaben … Dies ist die Aussage des Bildes, welches am Anfang dieses Artikels gezeigt wurde. Und das ist auch genau das, was die Tests, die wir im letzten Artikel zu diesem Thema betrachtet haben, implizieren. Ganz nach dem Motto:

Eine KI, die Schach spielen oder mehrere Sprachen sprechen kann, eine KI, die viel weiß, ist intelligent.

Über 100 Jahre der Intelligenzforschung mit zunehmend ausgeklügelten Intelligenztests und stetig präziseren Definitionen für Intelligenz; Die validesten Tests der Psychologie, sowie die weiteren Ansätze von Mathematik und Physik, welche das Potenzial aufweisen, die Intelligenz von jedem möglichen System, das existieren kann zu berechnen, werden hier von den Vertretern von KIs einfach in die Tonne getreten – nichtmal betrachtet -, um sie anschließend zu erstzen mit gar nichts. Leistung bei bestimmten Aufgaben ist genau die "Definition" von Intelligenz, die wir vor der Intelligenzforschung hatten. Einen Test bleibt man uns ebenfalls schuldig.

Turing Test

Der Turing Test soll die Intelligenz von Maschinen testen können.

Hierzu werden ein Mensch und eine Maschine mit einem "Tester" schreiben. Dieser "Tester" sieht lediglich die Nachrichten der Maschine und des Menschen. Wenn der Tester Mensch und Maschine nicht zuverlässig voneinander unterscheiden kann, dann wird die Maschine als intelligent betrachtet.

Allerdings testet man hier Ähnlichkeit mit Menschen und nicht Intelligenz.

Der Tester stellt folgende Fragen: "Was ist der richtige Gott?", "Was ist deine Lieblingsfarbe?", "Gib mir die abwegigste Antwort auf die Frage ‚Welche Fortbewegungsmittel die industrielle Revolution hervorgebracht hätte, wenn Menschen unter Wasser leben würden.’"

Menschen geben Antworten auf diese Fragen. Aber diese Antworten sind kein Produkt unserer Intelligenz. Dies sind alles "Probleme", welche mit logischen Denken und Gedächtnis nicht gelöst werden können. Eine KI, würde anders auf diese Fragen antworten als Menschen. Und somit kann diese von Menschen unterschieden werden und scheitert beim Turing Test. Es sei den KIs besitzen neben Intelligenz noch andere menschliche Eigenschaften …

Tun sie das?

Sollten sie das?

Fazit

Die Psychologie hat Definitionen und Tests für Intelligenz entwickelt, Physik und algorithmische Informationstheorie versuchen sie zu verbessern. Und die KI-Forschung hat größtenteils weder eine Definition von Intelligenz noch einen Test für diese.

Bildquellen

- Bezugsdiagramm Intelligenz: José Hernándes-Orallo, Fernando Martínez-Plumed, Ute Schmid, Michael Siebers, David L.. Dowe: Computer models solving intelligence test problems: Progress and implications, 2015. | All Rights Reserved

- Intelligenzdiagnostik im Vorschulalter. CHC-theoretisch fundierte Untersuchungsplanung und Cross-battery-assessment. Frühförderung interdisziplinär: Renner, G. & Mickley, M. (2015). Intelligenzdiagnostik im Vorschulalter. CHC-theoretisch fundierte Untersuchungsplanung und Cross-battery-assessment. Frühförderung interdisziplinär,16/22. | All Rights Reserved