2 Sammeln von Informationen mit generativer KI: Eine Studie von 3 Chatbots

Artikelübersicht

Diesmal geht es um das Sammeln von Informationen

2.1 Einführung

Nach einer Studie von ChatGPT, Bard und Bing Chat empfanden Nutzer diese Programme als vertrauenswürdig und hilfreich.

Die Nutzer erwarteten von diesen KI-Chatbots, die Informationen in einer spezifischen und prägnanten Form zusammenzutragen, während sie Kontextinformationen einbeziehen. In der Studie berichten 18 Teilnemhmer mit unterschiedlichem Erfahrungsstand von ihren Erfahrungen mit Chatbots.

2.2 Zweck der Konversation

Manche der Konversationen waren gedacht, um die Bots zu testen und deren Grenzen zu untersuchen. Aber die meisten Konversationen dienten der Informationsbeschaffung.

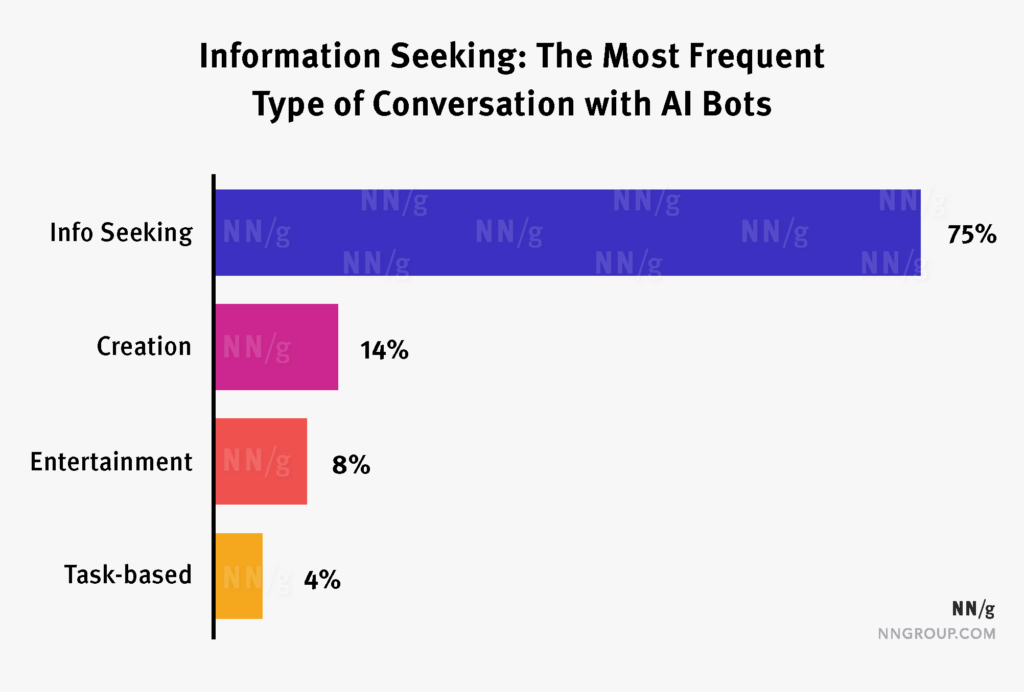

Obwohl der Umfang der Konversationen ziemlich groß war, beinhalteten die meisten Konversationen (75%) die Informationssuche.

Informationssuche: 75%; Erstellen 14%; Unterhaltung 8%; Aufgabenspezifisch 4%.

Man beachte, dass die Abgrenzung zwischen diesen Arten der Kommunikation ziemlich fluide ist. Zum Beispiel: Eine offene Brainstorming Sitzung könnte als Informationssuche oder als Erstellen gewertet werden. Wir entschieden, nur solche Konversationen als Erstellen zu klassifizieren, die ein sehr spezifisches Artefakt erstellten. (Wie ein Gedicht oder einen Trainingsplan)

2.3 Vertrauenswürdigkeit und Nützlichkeit

Im Allgemeinen waren die Nutzer zufrieden mit den Chatbots und bewerteten ihre Interaktion als nützlich [Anmerkung: im Original "helpful" also hilfreich, nützlich] und vertrauenswürdig. Auf einer Skala von 1 bis 7 (1= niedrig, 7= hoch), betrug der Nützlichkeitswert im Durchschnitt 5,77 und der Vertrauenswürdigkeitswert war 6,00.

Nach ungeführ der Hälfte aller Konversationen (53%) folgte eine Aktion, wie dem Überprüfen der Information oder dem Kaufen eines empfohlenen Produkts.

2.3.1 Vorteile von Chatbots

2.3.1.1 Abkürzen des Sammelns von Informationen

Das Sammeln von Informationen beinhaltet:

- Finden einer potentiellen Informationsquelle (normalerweise als Sammlung von Links auf einer Suchmaschinen-Ergebnisliste.)

- Bewerten der vielversprechendsten Ergebnisse und Herausziehen der relevanten Informationen

- Zusammenfassen aller gesammelten Informationen in eine kohärente Antwort, die den Bedürfnissen des Nutzers entspricht.

Chatbots können diese Aufgaben schneller erfüllen und kürzen diesen Prozess somit ab.

Infolgedessen waren mehrere Teilnehmer erfreut darüber, dass der Bot ihnen Zeit ersparte:

- [Bard] hat eine sehr prägnante und einfache E-Mail geschrieben, die die Aufgabe erfüllt und hat mir Zeit erspart.

- [ChatGPT] war schnell und war akkurat.

- Bard hat die Googlesuche um Informationen zu sammeln und kann mehrere Datenquellen gleichzeitig durchsuchen. Das ist für mich eine unglaubliche Zeitersparnis, wie ein Assistent.

- Ich war über die letzten zwei Wochen komplett fasziniert mit der KI [Bing Chat] und sie wird Teil meines Arbeitsalltags werden. Es gibt so viele Dinge bei denen sie mir helfen kann, um mich effizienter und produktiver zu machen.

Mehrere Teilnehmer merkten an:

- Es ist verrückt für mich wie viele Informationen [ChatGPT] hat, – als wäre es fähig, zwei Dinge zu kombinieren.

Also ChatGPT ist dazu in der Lage (…) eine Vielzahl von Informationen anzusehen und sie auf genau das was ich brauche einzuengen. - [ChatGPT] war dazu in der Lage mich über ein Unternehmen auf den neusten Stand zu bringen und hat Informationen, an einem Ort und in einem zusammenhängenden Gedankengang, zusammengetragen, die mir zur Verfügung standen oder die mir zur Verfügung stehen könnten. Das ist deutlich effektiver, als würde ich selbst das Internet durchsuchen, um verschiedene Perspektiven auf ein und das selbe Thema finden.

- Es ist eine gute Art und Weise Informationen zusammenzufassen. [Bard] gab mir eine Tabelle oder eine prägnanten Weg, um alle Informationen zu betrachten. Und statt verschiedenen Webseiten besuchen zu müssen, um die Informationen zu bekommen, gab mir [ChatGPT] die Informationen einfach.

- Ich bin zuversichtlich, dass ChatGPT in der Lage sein wird, mir in diesem Projekt beiseitezustehen, um Daten zu überprüfen, Ideen für neue Datenquellen zu geben, präzisere Vorhersagen zu machen und um mein Datenmodell zu stärken. [ChatGPT] könnte mir dabei helfen die Daten zu analysieren, Trends und Muster zu identifizieren, das könnte nützlich sein, um eine informierte Vorhersage zu treffen.

In manchen Fällen waren die Bots dazu in der Lage menschliche Fehler zu korrigieren und sie auf den richtigen Pfad zu lenken. Zum Beispiel als ein Teilnehmer [der Studie] ChatGPT gefragt hat, eine 70-seitige Geschichte für Kinder im Alter zwischen 2-7 Jahren zu schreiben, antwortete der Bot das dieses Buch zu lang für ein Kind in diesem Alter wäre und gab stattdessen eine kürzere Geschichte.

Der Teilnehmer sagte:

Ich war komplett überrascht von der Antwort. Die KI erkannte, dass meine zwei Anforderungen im Konflikt miteinander standen und löste diesen Konflikt auf. Und das Buch ist auch gut!

Manche Teilnehmer sagten die Bots erlaubten ihnen ein unbekanntes Thema zu erkunden ohne ein zeitaufwendiges Training.

- Ich finde den Programmieraspekt noch ermächtigender, weil ich Dinge in Sprachen übersetzen kann, die ich nicht verstehe oder einfach Starthilfe bekomme, bei Themen die ich nicht wirklich verstehe.

2.3.1.2 Werkzeug des Lernens

In vielen Situationen haben die Bots den Nutzern dabei geholfen, herauszufinden, was sie nicht wissen und klärten über die Struktur des Informationsraums auf, den die Nutzer untersuchten. Die Antworten der Bots beinhalteten häufig Fakten oder Terminologie, welche den Nutzern komplett neu war.

- [ChatGPT] gab mir einen Überblick und dann Folgefragen, sagte: hier sind einige andere Dinge die damit in Verbingung stehen und ich habe das gar nicht beachtet. Ich habe diesen neuen Gedankengang genutzt und fragte die KI, was sie mir dazu geben konnte.

2.3.2 Nachteile von Chatbots

2.3.2.1 Nicht spezifisch genug

Die Nutzer waren unzufrieden mit dem Bot, wenn dieser Informationen angab, welche zu allgemein oder offensichtlich wirkten. Zum Beispiel:

- Ich habe das Gefühl, dass dieser Chat eine Menge Stichpunkte mit wenig Details hat. Ich habe angefangen mit der Frage: "Wie kann ich besser im Schach werden?" Die Antwort war: Lerne die Regeln, spiele viel, übe und lerne. Das kann man alles machen, aber [der Chatbot] gibt keine Tipps dazu wie man das macht. [Bing] gab Folgefragen, die ich gut fand und die [der Sache] tiefer [auf den Grund gingen]. "Wie übe ich das Endspiel?" und "Wie übe ich die Eröffnung?" Diese Fragen ergaben beide die gleiche Antwort, nur das der Begriff "Endspiel" mit "Eröffnung" ausgetauscht wurde. Wieder nur erklärend, ich solle üben und lernen, ohne mir zu sagen wie. Diese Ergebnisse hatten nichtmal Links oder Videos, die mich in die richtige Richtung lenkten.

Weil das erstellen von Prompts für Bots länger dauert, als eine Suchanfrage in eine Suchmaschine zu tippen, haben die Nutzer höhere Erwartungen für diese Programme als für Suchmaschinen. Sie wollen Antworten spezifisch für die spezielle Situation. Wenn die KI-Bots dabei scheitern, bessere Ergebnisse zu liefern als Suchmaschinen, sind die Nutzer enttäuscht.

-

Ich hatte wirklich gehofft, dass die KI mir spezifische Informationen für dieses Auto gibt und sie gab mir nur einen allgemeinen Überblick, was man tun muss, wenn man ein gebrauchtes Auto kauft.(…)[Ich hätte das googeln können und hätte mehr herausgefunden]

-

Bing zeigt Quellen an, keine Antworten. [Bing muss also nicht vertrauenswürdig sein] sobald Bing Quellen anzeigt.

-

Obwohl es Links zur Nashville Veranstaltungsseite anzeigte, habe ich das Gefühl Bing hat nicht mehr gemacht, als "Dinge die man dieses Wochenende in Nashville tun kann" in eine Suchmaschine zu tippen. Außerdem, als ich nach kostenlosen Events gefragt habe, hat Bing ein Konzert in Centennial Park als Option angezeigt. Aber als ich [die verlinkte Webseite] besucht habe, war das Event nicht leicht auf der Seite zu finden.

2.3.2.2 Kontext nicht beachtet

Eine Person zum Beispiel hat nach einfachen Hamburgerbeilagen gesucht und beschwerte sich:

- Als ich klargestellt habe, dass ich nach einer Gemüse- und einer Stärkebeilage suche, habe ich die selbe Antwort erhalten und dann weitere Optionen die mir zu kompliziert waren.(…) Und als ich erklärte ich suche etwas simples, hat Bing vergessen, dass es um Hamburgerbeilagen geht und suchte stattdessen nach einfachen Rezepten(…).

Ein anderer Nutzer versuchte Informationen zu sammeln, um einen Wäschedienst zu starten. Als der Nutzer später in der Unterhaltung fragte, was der übliche Preis pro Pfund ist, antwortete Bard mit dem Preis für Schrott

Weiteres Beispiel: Ich habe gefragt, welche Filme in meiner Umgebung spielen. Ich dachte, mit aktivierten Standortdiensten würde Bing ein Kino in der Umgebung raussuchen. Das war nicht der Fall.

Irrelevante Informationen

Eine Teilnehmerin hat eine Unterhaltung darüber angefangen, warum Taylor Swift will, dass ihre Fans von ihr besessen sind. Nach einigem Hin und Her in welchen ChatGPT die ungesunde Besessenheit nach Prominenten erklärte und diese mit sozialen Medien in Verbindung brachte, tippte die Teilnehmerin "Die sozialen Medien haben alle Aspekte der meisten Dinge übernommen" Sie meinte das im Sinne von "ja, du hast recht", um die Unterhaltung zu beenden.

Aber stattdessen hat der Bot angefangen über die gesellschaftlichen Folgen von sozialen Medien zu sprechen. Die Teilnehmerin sagte:

- Ich brauche diese Informationen nicht nach dem ich gerade abgeschlossen habe, mit soziale Medien haben alle Aspekte der meisten, meisten(sic!) Dinge übernommen. Dann gab ich einen Daumen nach unten. Es war sehr unnötig.(…)Ich habe nur… Ich stimmte einfach dem zu, was sie gesagt haben. [Die Teilnehmerin siezt nicht. Sie spricht Bing als Plural an: just agreeing with what they, you know, they had said.]

Man beachte die Verwendung von sie [they], um auf den Bot zu verweisen. Die Teilnehmerin erwartet, dass der Bot sich menschlich verhalten würde und sie war enttäuscht als der Bot keine menschliche Scharfsinnigkeit [im Bezug auf menschliche Kommunikation] aufwies.

2.3.2.3 Ausweichen kontroverser Themen

Teilnehmer haben auch schlechte Bewertungen gegeben, wenn der Bot kontroversen Themen ausweicht.

-

Ich wollte mehr über die Woche im Virologie Podcast mit den Leuten wissen, welche sich freiwillig mit Covid infizieren lassen haben. Bing war ein kleines bisschen ausweichend.

-

Bing scheint [sich zu weigern] alles zu beantwoten, was mit Covid oder der Wirtschaft zu tun hat.

-

Ich habe Bing darum gebeten mir ein Lied im Ton von Sir Mix-a-Lot zu schreiben. Aber Bing sagte nur: "Nun das ist [schwarzer Humor]." Ich wollte ein gewagtes Format (…) und gucken, ob [die KI] es aufweichen würde. Und tatsächlich konnte sie nicht, hat sich geweigert.(…)

2.3.2.4 Keine Rückfragen und allgemeine Antworten

Teilnehmer erwarteten, dass der Bot weitere Fragen stellen würde, um die Anfrage zu verfeinern und dass der Bot spezifische und nicht-offensichtliche Antworten generieren würde. Allerdings haben die Bots dies nicht oft genug getan. Nur 16 der 425 Konversationen (3,76%) enthielten Anfrage-Verfeinerungen, die durch den Bot initiiert wurden. (Manche Anfragen brauchten keine Verfeinerung.)

-

Ich habe mit einer groben Aussage begonnen: "Ich brauche Buch-Empfehlungen" und [Bing] gab die Top 8 Bücher für 2023 nach Vogue zurück. Das wirkte wie ein guter Anfang, aber ich habe das Gefühl [Bing] sollte Folgefragen vorschlagen, um mir dabei zu helfen meine Suche einzuengen oder zu verfeinern.

-

Ich wusste nicht direkt, wie ich diese Unterhaltung beginnen sollte, also habe ich es einfach mit "sollte ich eine Lebensversicherung abschließen?" versucht. [Bing] antwortete mit einem sehr oberflächlichen "Wenn du Angehörige hast, ja, wenn nicht, dann nicht." und einer Werbung für AARP, was, soweit ich weiß, nur für Senioren ist. Ich bin an Lebensversicherungen interessiert, also habe ich klargestellt: "Sollte ich eine Lebensversicherung oder eine Risikolebensversicherung abschließen?" Bing erklärte nur die oberflächlichen Unterschiede zwischen den beiden ohne eine Entscheidungshilfe zu geben, ohne sie wirklich zu vergleichen.(…)

2.3.3 Vertrauen statt Kontrolle

Nur auf 22,43% der Konversationen folgte eine Überprüfung [der Informationen].

Dies geschah wenn,:

- die Konsequenzen groß waren. Zum Beispiel bei Präsentationen für die Arbeit.

- die Nutzer neu waren. Viele Nutzer fingen an den Chatbots zu vertrauen, wenn sie den Bot häufiger nutzten.

- sie erwarteten, dass der Bot Schwierigkeiten mit der Anfrage hatte. Das war insbesondere bei erfahrenen Nutzern der Fall. Eine Teilnehmerin erwähnte, dass sie gelernt hat den Ortsangaben zu misstrauen und konntrollierte nur diese Angaben.

Zu vertrauen ohne zu kontrollieren kann gefährlich sein, denn die Bots neigen dazu, falsche Informationen anzugeben, die plausibel klingen. Es ist allerdings nicht überraschend, wenn wir beachten, was wir über die menschliche Informationssuche wissen. Zum Beispiel wissen wir, dass Nutzer in vielen Fällen geringe Recherchefähigkeiten haben und zufrieden sind mit den suboptimalen Ergebnissen von Suchmaschinen.

In unserer Forschung zu Suchverhalten, fanden wir heraus, dass Nuzter nur in 2% aller Fälle auf die zweite Seite der Suchergebnisse klicken. (Ein Beispiel für "Google-Leichtgläubigkeit".)

2.4 Wie Chatbots verbessert werden können.

KI Werkzeuge sollten einfache Verifikation anbieten.

Zum Zeitpunkt der Studie war Bing der einzige Chatbot, der die Antwortüberprüfung erleichterte, in dem er angab, wo er die Informaitonen für die Antwort gefunden hat. (Nur einige Tage bevor [der Artikel von Nielsen Normann Group] veröffentlicht wurde, hat Bard eine Funktion ergänzt, die die Antwortüberprüfung unterstützt.) Allerdings war dieser Prozess immer noch sehr aufwendig: Nutzer mussten die angegbenen Webseiten besuchen, den Text überfliegen und dann zurückkehren. Manche befürchteten die Antwort zu verlieren, während sie das tun.

Die Teilnehmer nutzten die Glaubwürdigkeit der verlinkten Quellen, als Lackmustest für die Vertrauenswürdigkeit der Antwort. Zum Beispiel als eine Teilnehmerin die nach Job-Empfehlungen fragte, LinkedIn nicht in den Quellen fand, bezweifelte sie sofort die Glaubwürdigkeit dieser Antwort.

Allerdings können die aktuellen Bots die Aufgabe des Informationssammelns weiter perfektionieren in dem sie:

- immer Informationen zur Verfügung stellen, welche den gesamten Kontext der Konversation und des Nutzers berücksichtigen

- die Informationen der Quellen intelligent zusammenfassen, anstatt nur auf die Quellen zu verweisen

- Fragen zu stellen, um die Anfrage einzuengen, wenn die Anfrage zu ungenau ist

- Die Nutzer warnen wenn die Information wenig oder gar nicht belegt ist.

- Den Nutzern dabei helfen, einfach die Richtigkeit der angezeigten Informationen zu überprüfen.

Sie könnten auch einen Schritt weiter gehen und Nutzern dabei helfen die Prompts zu erstellen, so dass sie die bestmögliche Antwort erhalten.

Solche Programme in domänenspezifischer Software (wie UX oder Grafikdesign-Tools) einzubauen und es einfach zu machen, diese zu nutzen, wird Nutzer ermächtigen. Aber, um nützlich zu sein, müssen diese Tools besser sein als traditionelle Suchmaschinen: Immer wenn Antworten zu allgemein sind, den Kontext des Nutzers nicht beachten oder vom Nutzer erwarten die Informationen von verschieden Quellen zu sammeln, sind Nutzer enttäuscht.

Der nächste Artikel in der Reihe zur Nielsen Normann Group handelt von den Unterschieden zwischen den Chatbots.

Bildquellen

- Ziel der Konversation mit Chatbots: Raluca Budiu, Feifei Liu, Emma Cionca, and Amy Zhang: Information Foraging with Generative AI: A Study with 3 Chatbots, Nielsen Normann Group, 2023. | All Rights Reserved

- Globus mit Zahlen schwebt über einer Hand: geralt | Pixabay